大家好,本篇文章主要讲的是Linux下安装Hadoop集群详细步骤,感兴趣的同学赶快来看一看吧,对你有帮助的话记得收藏一下,方便下次浏览

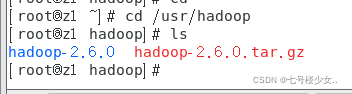

1.在usr目录下创建Hadoop目录,将安装包导入目录中并解压文件

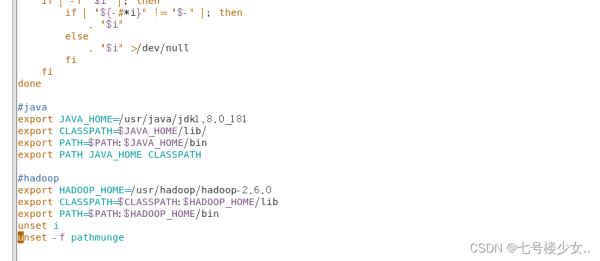

2.进入vim /etc/profile文件并编辑配置文件

#hadoop export HADOOP_HOME=/usr/hadoop/hadoop-2.6.0 export CLASSPATH=$CLASSPATH:$HADOOP_HOME/lib export PATH=$PATH:$HADOOP_HOME/bin

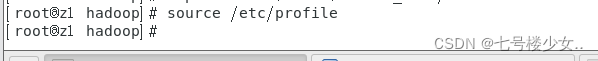

3.使文件生效

source /etc/profile

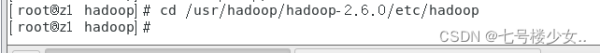

4.进入Hadoop目录下

cd /usr/hadoop/hadoop-2.6.0/etc/hadoop

5.编辑配置文件

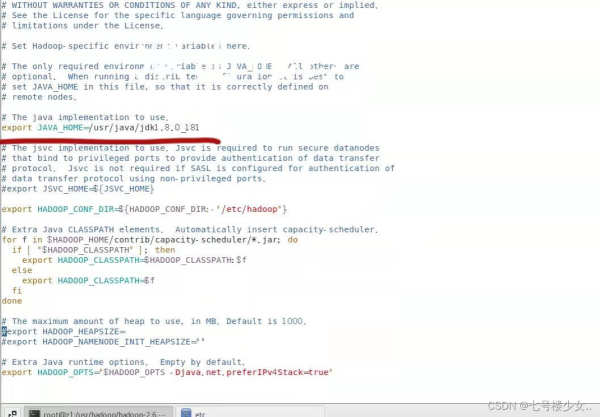

(1)进入vim hadoop-env.sh文件添加(java jdk文件所在位置)

export JAVA_HOME=/usr/java/jdk1.8.0_181

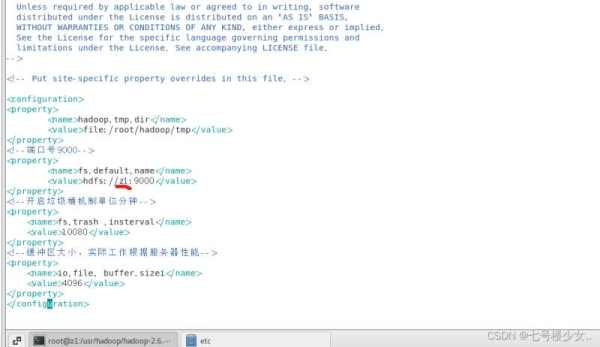

(2)进入 vim core-site.xml(z1:在主节点的ip或者映射名(改成自己的))

39,9 底端 hadoop.tmp.dir file:/root/hadoop/tmp fs.default.name hdfs://z1:9000 fs.trash .insterval 10080 io.file. buffer.sizei 4096

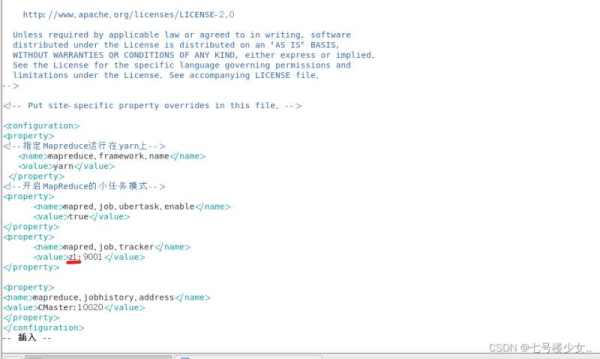

(3)Hadoop没有mapred-site.xml这个文件现将文件复制到这然后进入mapred-site.xml

cp mapred-site.xml.template mapred-site.xml vim mapred-site.xml

(z1:在主节点的ip或者映射名(改成自己的))

mapreduce.framework.name yarn mapred.job.ubertask.enable true mapred.job.tracker z1:9001 mapreduce.jobhistory.address CMaster:10020

(4)进入yarn-site.xml

vim yarn-site.xml

(z1:在主节点的ip或者映射名(改成自己的))

yarn.resourcemanager.hostname z1 The address of the appiications manager interface inthe RM. yarn.resourcemanager.address z1:8032 yarn.resourcemanager.scheduler.address z1:8030 yarn.resourcemanager.webapp.address z1:8088 yarn.resourcemanager.webapp.https.address z1:8090 yarn.resourcemanager.resource-tracker.address z1:8031 yarn.resourcemanager.admin.address z1:8033 yarn.nodemanager.aux-services mapreduce_shuffle yarn.scheduler.maximum-a11ocation-mb 2024 每个节点可用内存,单位M,默认8182MB yarn.nodemanager.vmem-pmem-ratio 2.1 yarn.nodemanager.resource.memory-mb 1024 yarn.nodemanager.vmem-check-enabled false yarn.nodemanager.aux-services.mapreduce.shuffle.class org.apache.hadoop.mapred.ShuffleHandler

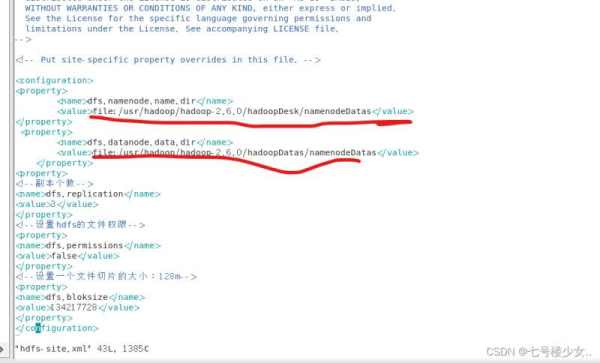

(5)进入hdfs-site.xml

vim hdfs-site.xml

dfs.namenode.name.dir file:/usr/hadoop/hadoop-2.6.0/hadoopDesk/namenodeDatas dfs.datanode.data.dir file:/usr/hadoop/hadoop-2.6.0/hadoopDatas/namenodeDatas dfs.replication 3 dfs.permissions false dfs.bloksize 134217728

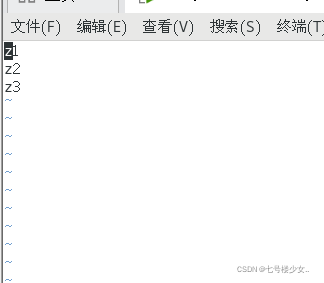

6.进入slaves添加主节点和从节点

vim slaves

添加自己的主节点和从节点(我的是z1,z2,z3)

7.将各个文件复制到其他虚拟机上

scp -r /etc/profile root@z2:/etc/profile #将环境变量profile文件分发到z2节点 scp -r /etc/profile root@z3:/etc/profile #将环境变量profile文件分发到z3节点 scp -r /usr/hadoop root@z2:/usr/ #将hadoop文件分发到z2节点 scp -r /usr/hadoop root@z3:/usr/ #将hadoop文件分发到z3节点

生效两个从节点的环境变量

source /etc/profile

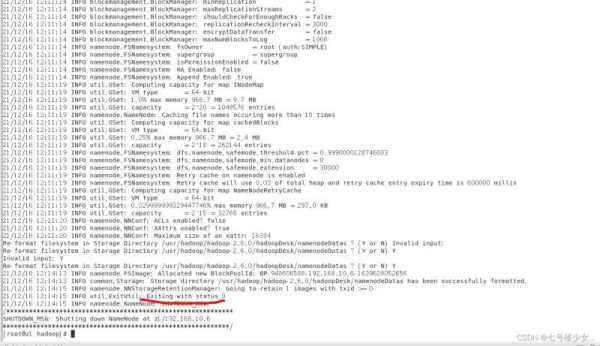

8.格式化hadoop (仅在主节点中进行操作)

首先查看jps是否启动hadoop

hadoop namenode -format

当看到Exiting with status 0时说明格式化成功

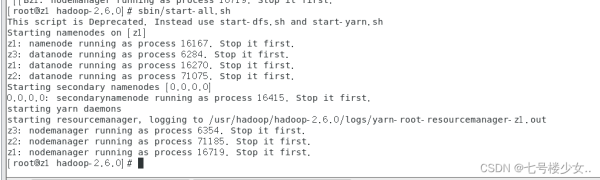

9.回到Hadoop目录下(仅在主节点操作)

cd /usr/hadoop/hadoop-2.6.0 sbin/start-all.sh 启动Hadoop仅在主节点操作

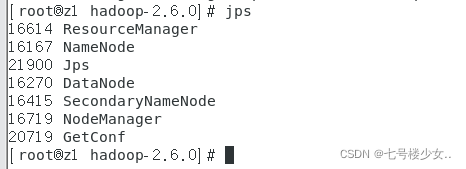

主节点输入jps效果:

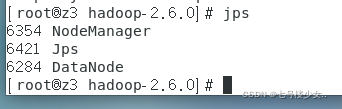

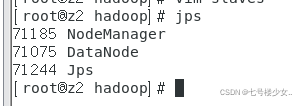

从节点输jps效果:

到此这篇关于Linux下安装Hadoop集群详细步骤的文章就介绍到这了,更多相关Linux安装Hadoop集群内容请搜索0133技术站以前的文章或继续浏览下面的相关文章希望大家以后多多支持0133技术站!

以上就是Linux下安装Hadoop集群详细步骤的详细内容,更多请关注0133技术站其它相关文章!